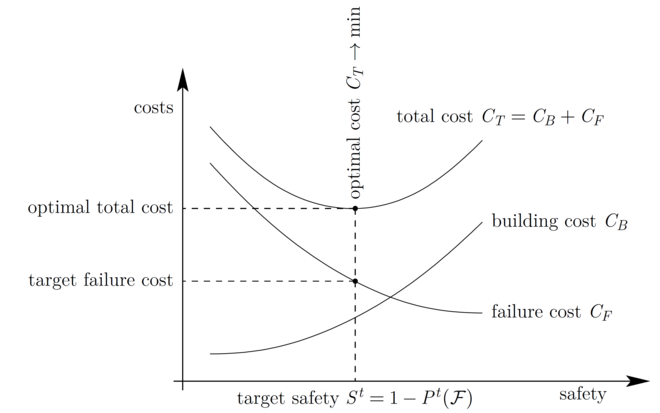

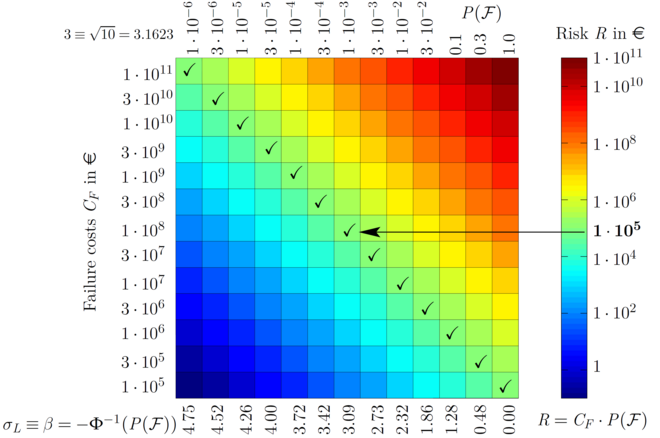

Bild: Aus den abgeleiteten Zielversagenkosten aller Komponenten eines komplexen Produktes oder eines Prozesses kann mittels einer abgeleiteten Risikomatrix ein vorgegebenes Gesamtrisiko der technischen Anlage oder des Produktionsprozesses eingehalten werden und für alle Komponenten die spezifische Zielausfallwahrscheinlichkeit abgeleitet werden. Unter Berücksichtigung dieser, können innerhalb einer toleranzrobusten Design- oder Prozessoptimierung optimale Komponenten im realen Einsatz entwickelt, hergestellt und deren Funktionalität und Qualität über die gesamte Lebensdauer garantiert werden.

Einleitung

Eine ureigenste Aufgabe einer u.a. natur- und wirtschaftswissenschaftlich ausgerichteten akademischen Forschungseinrichtung ist sowohl die angewandte wissenschaftliche Entwicklung von neuen innovativen Techniken, Verfahren, Produkten und Prozessen mit unmittelbarem Nutzungs-, Verwertungs- und Marktbezug als auch die grundlagenorientierte Forschung für eine ressourcen und umweltschonende Entwicklung einer wettbewerbsfähigen Wirtschaft. In meinen laufenden Forschungsaktivitäten werden u.a. einerseits mathematische Methoden erforscht

und weiterentwickelt und anderseits an unterschiedlichen Anwendungsbereichen der Luft- und Raumfahrt, des Schiffbaus, des Turbomaschinenbaus, der Speichertechnologien, der

Elektromotorenentwicklung und der chemischen Verfahrenstechnik erprobt. Die erfolgreiche Erforschung und Weiterentwicklung komplexer Algorithmen und Lösungsstrategien mit breitem

transdisziplinären Anwendungspotential gelingt in einer intensiven, interdisziplinären Forschungskooperation mit herausragenden universitären, wissenschaftlichen und industriellen

Partnern.

Zentrale Themen meiner aktuellen Forschungsarbeit sind die Entwicklung mathematischer Methoden der stochastischen Struktur- und Strömungssimulation, der Modellierung und der Finite-Elemente-Analyse von Zufallsfeldern und partieller stochastischer Differentialgleichungen, der Robustheits- und Zuverlässigkeitsanalyse innerhalb der Sicherheitstheorie, des maschinellen Lernens, der multidisziplinären Optimierung sowie die Numerik und Softwareentwicklung für die Entwicklung und Risikobewertung komplexer Systeme unter Berücksichtigung großer Datenmengen in den folgenden Technologien

- Industrie 4.0

- Cyber-physische Syteme

- Digital Twins

- Machine Learning

- Datenbasierte Optimierung

- Big Data Analysis

und den folgenden industriellen Anwendungsbereichen:

- Flexibilisierung der Kraftwerke, Energieeffizienz

- Erneuerbare Energien

- Speichertechnologien

- Turbomaschinen

- Automobilität

- Luft- und Raumfahrt

- Schifffahrt

- Medizintechnik

in Kooperation mit zahlreichen Partnern aus Universitäten sowie zahlreichen Industrie- und außeruniversitären Forschungseinrichtungen, wie z.B.:

- Hochschulen: RWTH Aachen, Ruhr-Universität Bochum, Technische Universität Braunschweig, Technische Universität Dresden, Leibniz Universität Hannover, TU-Darmstadt

- Forschungseinrichtungen: DLR Köln

- Unternehmen: Robert Bosch GmbH, Siemens AG, Rheinmetall Automotiv, Rolls-Royce Deutschland, DNV GL, M.TEC GmbH, DYNARDO GmbH, CADFEM GmbH, Friendship Systems

Probabilistic Intelligence - neue Verfahren der künstlichen Intelligenz für robuste und effiziente Produkte und Prozesse

Zweifellos wird immer offensichtlicher, dass künstliche Intelligenz immer mehr unsere Gesellschaft und unsere Art, in dieser zu leben maßgeblich beeinflusst. Die derzeitig verwendeten Verfahren des maschinellen Lernens haben bereits vieles mit der Art und Weise, wie unser menschliches Gehirn arbeitet, gemeinsam. Zwar sind Computer, im Gegensatz zu uns Menschen, in der Lage, sehr viele hoch genaue Berechnungen in beliebig hoch dimensionalen Räumen in einer Sekunden durchzuführen, jedoch ist das Lernen von Menschen dem der Computer in vielen Aspekten weit überlegen. Z.B. kann menschliches Lernen kontinuierlich Wissen akkumulieren und sich an zufällig ändernden Einflüssen aus der Umgebung anpassen. Die menschlichen Fähigkeiten sind nicht auf einen einzigen bestimmten Zweck trainiert, sondern zunächst einmal sehr universell, können aber auch durch langes Lernen spezialisiert werden. Dennoch kann in dieser Lernphase das Verarbeiten neuer Informationen in Sekunden erfolgen. Außerdem haben die Menschen die Fähigkeit des aktiven Lernens. Wir können gezielt Fragen stellen, um besonders relevante Informationen zu bekommen und wir können zwischen Wichtigem und Unwichtigem unterscheiden. Intuitiv können wir fehlende Informationen ergänzen und haben ein Gefühl für die Wahrscheinlichkeit einer richtigen Antwort auf eine Frage. Dabei kommt es den Menschen nicht so sehr auf eine möglichst genaue Vorhersage aufgrund der erlernten Erfahrungen an, sondern es genügt häufig eine ungefähre Abschätzung. All diese Fähigkeiten macht menschliches Lernen effektiver, effizienter und schneller im Vergleich zum maschinellen Lernen. Wird maschinelles Lernen um diese Fähigkeiten erweitert, kann die Vorhersagewahrscheinlichkeit der richtigen Antworten um ein Vielfaches gesteigert und der Speicher- und Rechenbedarf drastisch reduziert werden, so dass neue Anwendungsbereiche der künstlichen Intelligenz kostengünstig erschlossen werden können.

Cyber-Physische-Systeme und digitale Zwillinge

Ein strategisches Ziel der Hightech-Strategie 2020, welches gleichsam ein Leitthema der nationalen Nachhaltigkeitsstrategie darstellt, ist die Erforschung von Schlüsseltechnologien für die digitale Wirtschaft und Gesellschaft. Voraussetzung für das Erreichen dieses Zieles ist die praxisnahe Kombination mathematischer Grundlagenforschung mit der Produkt- und Prozessentwicklung z.B. durch die Nutzung effizienter Algorithmen für die Analyse großer Datenmengen zur ressourcenschonenden und energieeffizienten Produkt- und Prozessoptimierung. Mit den Begriffen Digitalisierung und Industrie 4.0 werden Grundlagenforschung und Produktentwicklung sowie Produktion eng mit den modernen Informations- und Kommunikationstechnologien verknüpft. Technische Grundlage für das Zusammenwachsen von realer und virtueller Welt sind intelligente, vernetzte Systeme, mit denen digitale Entwicklungsprozesse sowie Analyse und Optimierung großer Datenmengen in Echtzeit möglich sind.

Auf der Basis so genannter Cyber-Physischer-Systeme (CPS) entwickelt das IMH dynamische, echtzeitfähige und selbstorganisierende Wertschöpfungsketten, die sich nach verschiedenen Zielgrößen, wie beispielsweise Kosten, Verfügbarkeit, Energie- und Ressourcenverbrauch, Flexibilität, Durchlaufzeit etc. optimieren lassen. CPS können über Softwarewerkzeuge Informationen und Wissen aus realen Zustands- und Prozessdaten nutzen und über anwendungsspezifische Engineering-Applikationen ein digitales, virtuelles Abbild der physikalischen Systeme simulieren. Jede Änderung einer Komponente kann dabei in das virtuelle Abbild zurückgespielt werden. Somit bekommen physische Produkte ein zugeordnetes, numerisches Modell, das im Aktionsfeld Industrie 4.0 auch als digitaler Zwilling (engl. Digital Twins) bezeichnet wird. CPS können in Komponenten, Maschinen und Anlagen integriert werden, die sich durch Selbstoptimierung und Rekonfiguration an sich ändernde Betriebsbedingungen anpassen können.

Big Data Analysis

Das reale, physikalische System erzeugt im tatsächlichen Betrieb über Sensoren Werte für die Datenanalyse im digitalen Modell, die wiederum über die datenbasierte Optimierung den Betriebsprozess beeinflusst. Zudem lassen sich über Echtzeitdaten von Sensoren standortunabhängig

Informationen über den Zustand des physikalischen Systems abrufen, so dass auch die Vorhersage von Fehlfunktionen möglich wird. In den Anwendungsszenarien der Industrie 4.0 fallen große Datenmengen (Big Data) an. Komponenten und Maschinen werden mit zusätzlicher Sensorik und leistungsfähigeren Steuerungen ausgestattet. In den Forschungsprojekten des IMH werden Algorithmen entwickelt, damit Daten nicht nur gesammelt, sondern intelligent miteinander verknüpft und analysiert werden können, um relevante Zusammenhänge herzustellen, Schlüsse zu ziehen - und das in vielen Anwendungsfällen in Echtzeit.

Machine-Learning-Algorithmen und stochastische Optimierungsverfahren

Als Schlüsseltechnologie für die Entwicklung von CPS gilt das maschinelle Lernen (engl.: Machine Learning). Das IMH befasst sich innerhalb des Machine Learnings u.a. mit der automatisierten Entwicklung von Metamodellen basierend auf empirischen Daten bzw. Trainings-Daten. Statt teurer Prototypen und langwieriger Versuchsketten lassen sich so mit Digital Twins anhand von Machine-Learning-Algorithmen datenbasierten Optimierungen innerhalb kürzester Zeit durchspielen, Lösungsstrategien entwickeln und verwerfen, Verbesserungsmöglichkeiten ausloten und umsetzen.

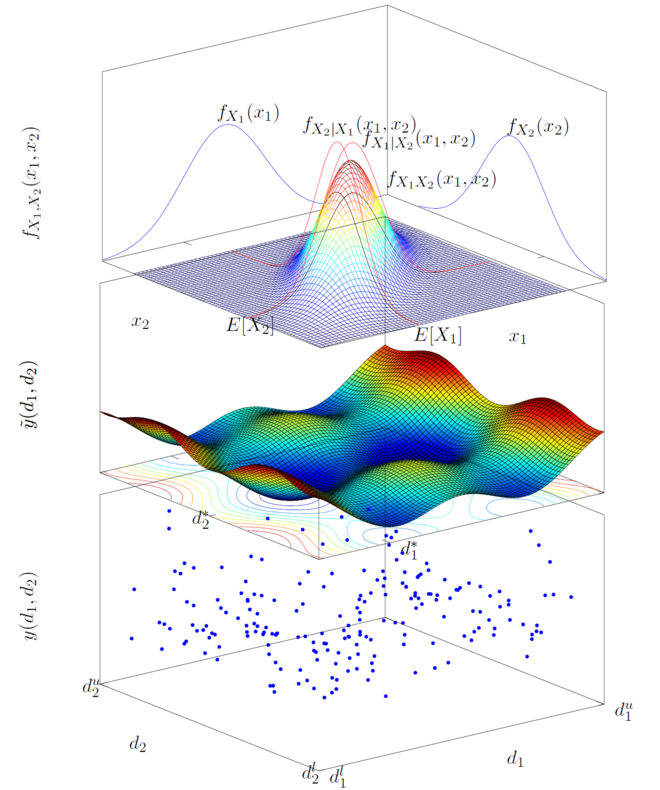

Mit Machine-Learning-Algorithmen und stochastischen Optimierungsverfahren, die in den Forschungsprojekten des IMH entwickelt werden, können intelligente Wertschöpfungsketten realisiert werden, die zudem alle Phasen des Lebenszyklus des Produktes mit einschließen - von der Idee eines Produkts über die Entwicklung, Fertigung, Nutzung und Wartung bis hin zum Recycling. Ferner kann eine schnelle Umsetzung von Kundenanforderungen über Cloud-Systeme und eine bedarfssynchrone Entwicklung bei individualisierter Produktion in immer kürzeren Produktzyklen zu niedrigeren Kosten ressourcenschonend und nachhaltig realisiert werden. Für eine effiziente, multidisziplinäre, datenbasierte Optimierung werden heute im Wesentlichen Metamodellierungsverfahren des Machine Learnings (ML) entwickelt. Die Systemantworten werden dabei auf einem Satz von Versuchsdaten oder Analysen des CPS mittels Metamodelle approximiert bzw. interpoliert.

In eigenen Forschungsergebnissen konnte mittels eines anisotropen, inhomogenen ML-Verfahrens in Kombination mit adaptiven Designplänen gezeigt werden, dass ML-Meta-Modelle sehr effizient auch für die stochastische Analyse der Sicherheit und Zuverlässigkeit und damit für die stochastische Optimierung komplexer technischer Systeme verwendet werden können.

Durch maschinelles Lernen können große Datenmengen aber nur für wenige Mess- bzw. Ergebnisgrößen in Beziehung gesetzt und wichtige lineare Einflussparameter identifiziert werden, da die Algorithmen der Metamodellierung und Sensitivitätsanalyse sehr rechenzeitintensiv sind. Somit sind die herkömmlichen Algorithmen des Machine Learnings und der Big Data Analysis nicht für eine nichtlineare, multivariate Parameteridentifikation und für zeit- bzw. ortsabhängige Mess bzw. Ergebnisgrößen geeignet, da die Analyse für jeden zeit- bzw. ortsdiskretisierten Wert, z.B. für bis zu mehrere Millionen Mess- bzw. Ergebnispunkte, durchgeführt werden müsste. In bereits beantragten Forschungsprojekten sollen effiziente ML-Algorithmen entwickelt werden, um sowohl zeit- als auch ortsabhängige Big-Data-Analysen zu ermöglichen.

Künstliche Neuronale Netzwerke

Eines der oft genutzten Verfahren im Bereich des ML sind neuronale Netze (NN). Durch die verhältnismäßig einfachen, mathematischen Operationen sind diese Verfahren auch für Big-Data-Anwendungen geeignet. NN lassen sich gut auf CPU- bzw. GPU-basierten Hardwareplattformen parallelisieren und durch sogenanntes Batch oder Online Learning für beliebig große Datenmengen anwenden. Beim Batch Learning werden die Daten in Pakete aufgeteilt und die Hyperparameter des NN nach der Auswertung jedes einzelnen Paketes angepasst. Beim Online Learning erfolgt die Anpassung nach jedem einzelnen Datenpunkt, so dass fortlaufend das Model an neuen Trainingsdaten angepasst werden kann. Dabei ist die Abarbeitung der Datenpakete und somit das verteilte Lernen parallel möglich, z.B. durch die Aufteilung auf verschiedenen Rechenknoten eines Clusters.

NN können komplexe Zusammenhänge darstellen und lassen sich auf die verschiedensten Anwendungsgebiete anpassen. So sind beispielsweise rekurrente und long short-term memory

(LSTM) Netze für sequentiell abhängige Daten (Zeitreihen, Sprache, Text) besonders gut geeignet. Convolutional neural networks sind Netzwerke die sich für Audio- und Bild-Daten eignen und z.B. bei der Bilderkennung und im autonomen Fahren verwendet werden. Eine der Schwächen von neuronalen Netzen liegt in der Gefahr des Overfitting bei sehr kleinen Datensätzen, sowie einer häufig schlechteren Prognosequalität im Vergleich zu anderen Methoden. Darüber hinaus ist die Auswahl der Netztopologie und der Aktivierungsfunktionen, die für die nicht-lineare Datentransformation sorgen, sowie die Initialisierung der Hyperparameter entscheidend für die Performance des Meta-Models und müssen in den meisten Fällen aus notwendigem Expertenwissen generiert werden.

Gaußprozesse

Gaußprozesse (GP) stellen ein weiteres Verfahren aus dem Bereich des ML dar. Sie eignen sich insbesondere im Bereich der Regression auch für minimale Datensätze. Sie übertreffen in den meisten Fällen die Prognosegenauigkeit vieler anderer Verfahren. Zudem ermöglichen GP die Abschätzung der Varianz der Vorhersage, welche dazu genutzt werden kann, Konfidenzintervalle und -bereiche zu berechnen. Dies erhöht die Zuverlässigkeit der Algorithmen hinsichtlich der Angabe einer Fehlerwahrscheinlichkeit und der Prognosequalität der gefundenen Lösung. Aufgrund der komplexen mathematischen Operationen ist die Anwendung der GP auf große Datenmengen

im Vergleich zu NN wesentlich rechenzeitintensiver.

In eigenen Forschungsarbeiten wurde mithilfe von Dimensionsreduzierungsmethoden gezeigt, dass auch mit minimalen Datensätzen erfolgreich Vorhersagemodelle gebildet werden können. Neben der Untersuchung anderer Verfahren des ML wurden neue Entwicklungen von anisotropen GP an verschiedenen Beispielen aus dem Turbomaschinenbau und der Elektromobilität erfolgreich eingesetzt. Dabei konnte gezeigt werden, dass diese auch dann eine hohe Prognosegüte liefern, wenn nur eine geringe Anzahl an Trainingspunkten verwendet werden kann. In einer weiteren Forschungsarbeit wurde erprobt, wie sich verschiedene ML-Modelle miteinander lokal kombinieren lassen. Basierend auf dem Cross-Validierungsfehler und abgeleiteter Konfidenzbereiche wurde die Prognose der einzelnen Modelle gewichtet, abhängig von der Lage des zu approximierenden Datenpunktes im Designraum. Diese Vorgehensweise würde sich ebenfalls für die Kopplung von Approximations- und physikalischen Modellen eignen.

Kovarianznetzwerke

In zukünftigen Forschungsschwerpunkten des IMH soll u.a. herausgefunden werden, wie sich die positiven Eigenschaften von NN mit denen der GP kombinieren lassen, z.B. durch die Nutzung der GP als Aktivierungsfunktion innerhalb des NN. Erste Arbeiten in diese Richtung wurden kürzlich veröffentlicht. Bei sogenannten Deep Gaussian Processes werden mehrere GP hintereinandergeschaltet. Dabei wird, wie bei NN, eine Netztopologie aufgebaut.

Weiterhin sollen diese sogenannten Kovarianznetzwerke mit rekurrenten und Convolutional- Netzen kombiniert werden. Durch die Kombination von GP und NN sollen die Vorteile der Algorithmen, z.B. die gleichzeitige Verwendbarkeit von kontinuierlichen und diskreten Parametern, bestehen bleiben und deren Nachteile, z.B. bzgl. der beschränkten Anwendbarkeit auf minimale Datensätze, eliminiert werden. Darüber hinaus soll diese Kombination auch für zeitabhängige Ausgangsgrößen effizient anwendbar gemacht werden. Ein weiterer Aspekt betrifft die Aufbereitung der Daten bzw. auch die intelligente Reduzierung der Dimensionen, sowie der Datenpunkte. Beispielsweise kann in vielen Anwendungsfällen mit Hilfe einer Hauptkomponenten-Analyse die Anzahl der notwendigen Dimensionen reduziert werden. Alternativ sollen auch Autoencoder verwendet werden, um eine nicht-lineare Kompression der Dimensionen durchzuführen. Dies würde u.U. zu einer Verbesserung der Qualität der Eingabedaten führen und die Flexibilität gegenüber sich verändernden Datendimensionen steigern.